El dispositivo identifica las emociones del usuario y luego las traduce en emojis.

Ithaca, Nueva York–Los investigadores de la Universidad de Cornell han inventado un auricular que puede rastrear continuamente las expresiones faciales completas al observar el contorno de las mejillas y luego puede traducir las expresiones en emojis o comandos de voz silenciosos.

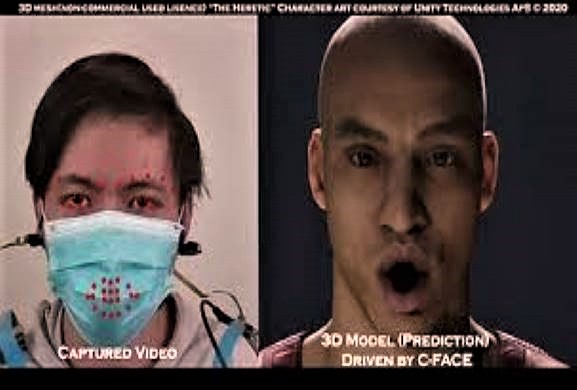

Con el dispositivo montado en la oreja, llamado C-Face, los usuarios pueden expresar emociones a los colaboradores en línea sin tener que sostener cámaras frente a sus caras, una herramienta de comunicación especialmente útil ya que gran parte del mundo se dedica al trabajo o aprendizaje remoto.

Con C-Face, los avatares en entornos de realidad virtual podrían expresar cómo se sienten realmente sus usuarios y los instructores podrían obtener información valiosa sobre la participación de los estudiantes durante las lecciones en línea. También podría usarse para dirigir un sistema informático, como un reproductor de música, utilizando solo señales faciales.

«Este dispositivo es más simple, menos molesto y más capaz que cualquier tecnología portátil existente para rastrear expresiones faciales», dijo Cheng Zhang, profesor asistente de ciencia de la información y autor principal de «C-Face: Continuously Reconstructing Facial Expressions by Deep Learning Contornos de la cara con cámaras en miniatura montadas en la oreja.” El documento se presentará en el Simposio de la Asociación de Maquinaria de Computación sobre Software y Tecnología de Interfaz de Usuario, que se celebrará virtualmente del 20 al 23 de octubre.

«En la tecnología portátil anterior que tenía como objetivo reconocer las expresiones faciales, la mayoría de las soluciones necesitaban colocar sensores en la cara», dijo Zhang, director del SciFi Lab de Cornell, «e incluso con tanta instrumentación, solo podían reconocer un conjunto limitado de expresiones faciales discretas.»

Debido a que funciona detectando el movimiento muscular, C-Face puede capturar expresiones faciales incluso cuando los usuarios usan máscaras, dijo Zhang.

El dispositivo consta de dos cámaras RGB en miniatura: cámaras digitales que capturan bandas de luz roja, verde y de luz, ubicadas debajo de cada oreja con auriculares o audífonos. Las cámaras registran los cambios en los contornos faciales que se producen cuando los músculos faciales se mueven.

Una vez que se capturan las imágenes, se reconstruyen utilizando visión por computadora y un modelo de aprendizaje profundo. Dado que los datos sin procesar están en 2D, una red neuronal convolucional, una especie de modelo de inteligencia artificial que es bueno para clasificar, detectar y recuperar imágenes, ayuda a reconstruir los contornos en expresiones.

El modelo traduce las imágenes de las mejillas a 42 puntos de rasgos faciales, o puntos de referencia, que representan las formas y posiciones de la boca, los ojos y las cejas, ya que esos rasgos son los más afectados por los cambios de expresión.

Estas expresiones faciales reconstruidas representadas por 42 puntos de características también se pueden traducir a ocho emojis, incluidos «natural», «enojado» y «cara de beso», así como ocho comandos de voz silenciosos diseñados para controlar un dispositivo de música, como «reproducir , «» siguiente canción «y» subir volumen.»

La capacidad de dirigir dispositivos mediante expresiones faciales podría ser útil para trabajar en bibliotecas u otros espacios de trabajo compartidos, por ejemplo, donde las personas no quieran molestar a los demás hablando en voz alta.

Traducir expresiones a emojis podría ayudar a quienes participan en colaboraciones de realidad virtual a comunicarse de manera más fluida, dijo Francois Guimbretière, profesor de ciencia de la información y coautor del artículo de C-Face.

Una limitación de C-Face es la capacidad limitada de la batería de los auriculares, dijo Zhang. Como próximo paso, el equipo planea trabajar en una tecnología de detección que use menos energía.

La investigación fue apoyada por el Departamento de Ciencias de la Información de la Universidad de Cornell.

Video anexo: YouTube